Die richtige Kurve kriegen | Fachartikel zur besseren Risikoeinschätzung durch angepasste Modellierung und Zielgrößen

Zur Quantifizierung von Risiken werden üblicherweise drei Werte geschätzt, mit deren Hilfe eine Darstellung mit Drei-Punkt-Verteilung erstellt wird: der Minimalwert (Best Case), der Maximalwert (Worst Case) und der wahrscheinlichste Wert (Most Likely Case). Solche Verteilungen sind auch ohne statistische Vorkenntnisse intuitiv und schnell zu erstellen.

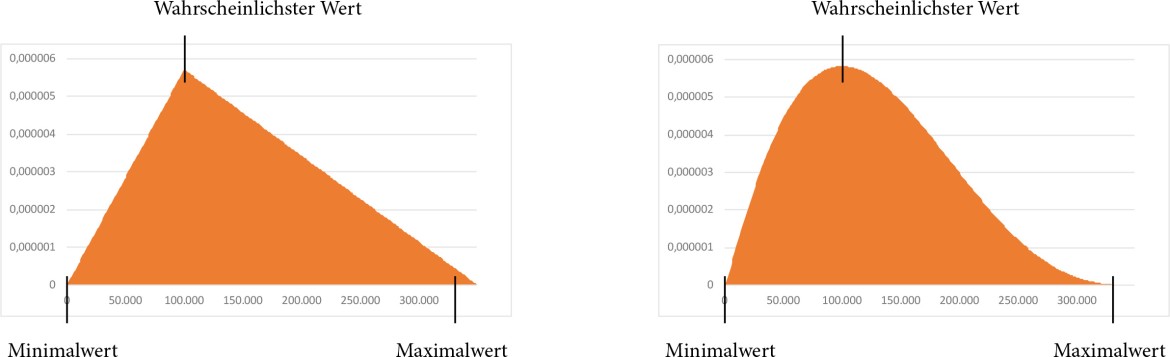

Die Standardverläufe, die dadurch entstehen, lassen sich durch eine Vielzahl verschiedener Verteilungen abbilden, beispielsweise als Dreieck oder als Kurve (PERT-Verteilung, kurz für „Project Evaluation and Review Technique“). Beide Darstellungen beginnen beim Minimalwert, enden beim Maximalwert und weisen den höchsten Punkt am wahrscheinlichsten Wert auf. Die damit quantitativ dargestellten Risiken sind klar begrenzt und ihre Verlaufsformen ähneln sich alle: Während ein Dreieck gerade Linien und eine Spitze aufweist, verläuft eine PERT-Verteilung als Kurve mit einem Hochpunkt und einem sanfteren Abfall in Richtung Maximalwert (Abb. 1).

In ihrer standardisierten Darstellung und der Begrenzung der Risiken liegen jedoch auch die Schwächen der Drei-Punkt-Verteilungen: Werte und Grenzen müssen korrekt gesetzt werden, um den daraus entstehenden Verlauf realistisch abzubilden – das kann mit Extremwerten und festen Grenzen nicht gelingen. Nicht jedes Risiko ist in seiner Wirkung begrenzt. Und um einen besten und einen schlimmsten anzunehmenden Fall (Chance und Risiko) sowie den wahrscheinlichsten Fall für ein Unternehmen präzise einschätzen zu können, reicht auch langjährige Erfahrung meist nicht aus. Risiken passen nicht in ein Schema – und somit können Standardverläufe mit Extremwerten und harten Grenzen ihnen nicht gerecht werden.

Abbildung 1: Verlauf einer Dreiecks- und einer PERT-Verteilung (kurz für „Project Evaluation and Review Technique“).

„Weiche“ Grenzen und Quantile

Wichtig ist eine Vereinfachung der Risikoeinschätzung, die es ermöglicht, realistische und fundierte Werte (Parameter) zu bestimmen, die sich begründen und validieren lassen. Hierfür muss man zunächst akzeptieren, dass Risiken unbegrenzt sein können und absolute Ober- und Untergrenzen unzureichenden Spielraum aufweisen.

Zu hoch oder zu niedrig gesteckte „harte“ Grenzen haben zur Folge, dass Teile des Risikos übersehen werden, die sich außerhalb dieser Grenzen befinden. Sind die maximalen Auswirkungen eines Risikos nicht abzuschätzen, würde eine intuitiv festgelegte Grenze das Unternehmen für Risikoauswirkungen oberhalb des Grenzwerts blind machen. Im Eintrittsfall wäre das Unternehmen für Auswirkungen einer solchen Höhe dann nicht gewappnet. In der Praxis kann das zu einer Überschätzung der Risikotragfähigkeit eines Unternehmens führen.

Mithilfe von Quantilen in Kombination mit jeweils einem prozentualen Grad an Sicherheit („zu 10 % sicher“, „zu 70 % sicher“ ...) lassen sich „weiche“ Grenzen bestimmen: von einem „Realistic Best Case“ zu einem „Realistic Worst Case“. So wird schrittweise zu einem bestimmten Prozent an Sicherheit geschätzt, dass die zu erwartenden Auswirkungen eines betrachteten Risikos unter oder über dem angesetzten Wert liegen. Dadurch ergeben sich flexiblere Eingangsdaten für das spezifische Risiko, dessen Verlauf sich so präziser darstellen und mit einer Polynom-Verteilung abbilden lässt.

Polynom-Verteilung

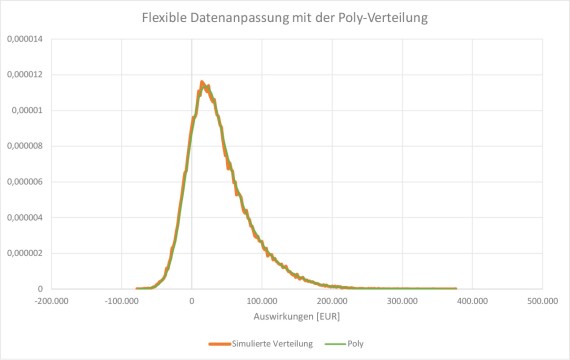

Eine Polynom-Verteilung (kurz: Poly-Verteilung) ermöglicht eine flexible Anpassung an den individuellen Verlauf eines Risikos. Anders als bei Drei-Punkt-Verteilungen ist eine Poly-Verteilung (in der Grafik grün abgebildet, dem Verlauf der orangenen simulierten Verteilung folgend) weder an Grenzen noch eine feste Form gebunden – sie verfügt über eine variable Form, die automatisch extrapoliert wird und sowohl beidseitig begrenzt oder unbegrenzt als auch einseitig begrenzt sein kann. Charakteristisch sind dabei flach abfallende Ausläufer – in Richtung Maximum zieht dieser sich besonders lang hin. So werden auch unwahrscheinlichere Szenarien mit sehr hohen Verlusten (Very Bad Cases) berücksichtigt. Für eine Poly-Verteilung benötigt man drei oder mehr Parameter.

Alternativ gibt es noch die sogenannte Expert-Verteilung: eine besondere Abwandlung der Poly-Verteilung, die auf exakt drei Quantilen (ein realistischer oberer und unterer Wert sowie der Median) und optionalen Grenzwerten basiert. Dadurch verbindet sie die einfache Handhabung der Drei-Punkt-Verteilungen mit der Flexibilität der Poly-Verteilung.

Disaggregation und Monte-Carlo-Simulation

Zur realistischeren Einschätzung eines Risikos empfiehlt es sich, dieses in seine einzelnen Bestandteile aufzubrechen – also die vielen Faktoren, aus denen es sich zusammensetzt (sog. Disaggregation). Diese lassen sich gesondert voneinander leichter beurteilen und im Anschluss mittels Monte-Carlo-Simulation wieder zu einem Gesamtwert zusammenrechnen. Durch so eine methodische Bewertung können die Parameter feiner und genauer gesetzt werden.

Mit einer Monte-Carlo-Simulation lassen sich anhand eines mathematischen Verfahrens Experteneinschätzungen noch weiter fundieren: Dazu werden die korrelierenden Unsicherheiten, die ein Risiko treiben, mehrere tausend Mal simuliert, um anschließend eine möglichst genaue Prognose der Ergebnisse erstellen zu können. Eine Monte-Carlo-Simulation erzeugt also eine realistische Häufigkeitsverteilung der Auswirkungen eines Risikos.

Methodenvergleich

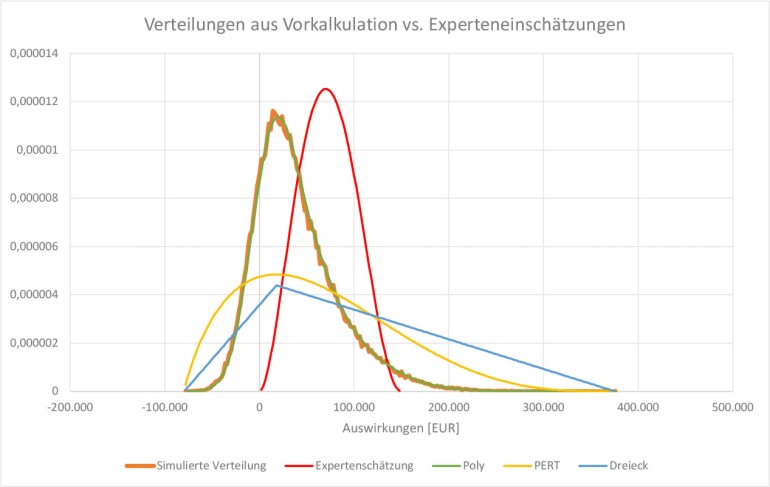

Im direkten Vergleich (Abb. 3) ist auf den ersten Blick erkennbar, dass die Poly-Verteilung als einzige die simulierten Eingabedaten realistisch wiedergeben kann. Aufgrund ihrer Flexibilität legt sie sich präzise über den Verlauf der Gewinne/Verluste und übernimmt deren Form.

Die Dreiecks- und PERT-Verteilungen weisen hingegen durch ihre standardisierten Verläufe starke Abweichungen von den Eingabedaten auf. Zwar stimmen Minimal- und Maximalwert damit überein, doch die Eintrittswahrscheinlichkeit des wahrscheinlichsten Wertes wird deutlich unterschätzt, während große Chancen und Verluste dramatisiert und überschätzt werden.

Auch eine Einschätzung durch Experten – zumindest ohne zugrunde liegende Vorkalkulation – deckt sich kaum mit simulierten Eingabedaten: Der wahrscheinlichste Wert wird im Beispiel zu hoch geschätzt, die Chancen etwas zu gering und extrem negative Auswirkungen als unverhältnismäßig wahrscheinlich eingestuft – dabei wurde allerdings der Maximalwert trotzdem zu niedrig gesetzt, sodass sehr hohe, wenn auch sehr unwahrscheinliche Risiken ausgeklammert werden.

Abbildung 3: Vergleich einer Dreiecks- (blau), PERT- (gelb) und Poly-Verteilung (grün) sowie einer Experteneinschätzung (rot) mit realistischen Eingabedaten (orange).

Experiment: Extremwert-Schätzung versus Quantile und weiche Grenzen

In Risikomanagement-Seminaren des Autors wurden fünfzig Experten für ein Experiment gebeten, ihre Einschätzung zu dem Risiko eines fiktiven Projekts abzugeben, das aus zehn Teilaufgaben (Unsicherheiten) besteht. Die Aufgabenstellung besagte, dass jeder Projekttag 5000 € kostet und das Projekt erst abgeschlossen ist, wenn die letzte Aufgabe beendet ist. Das zu beurteilende Risiko dabei war die Planabweichung. Das Experiment zielte darauf ab, zu zeigen, dass schon die Bewertung eines solchen idealtypisch einfachen Projekts schwer zu bewerkstelligen ist – besonders bei der Nutzung von Extremwerten. Daher wurden sowohl die Einschätzung von Extremwerten als auch die Einschätzung von Quantilen und weichen Grenzen mit einem Monte-Carlo-Simulationsverlauf verglichen.

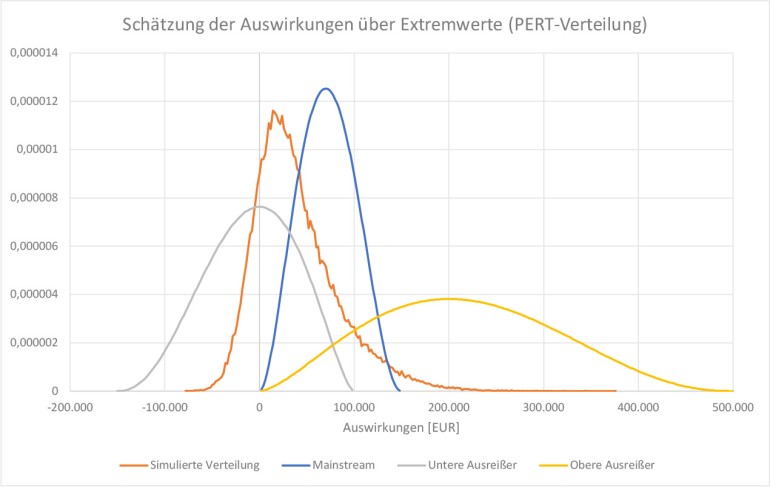

Die Experteneinschätzungen mittels Extremwerten unterschieden sich mit Abweichungen von bis zu 500 % erheblich. Der Most Likely Case wurde überwiegend circa mittig zwischen Best und Worst Case platziert, was zeigt, wie schwierig der „wahrscheinlichste“ Fall einzuschätzen ist. Abbildung 4 verdeutlicht, dass zwar die Mehrheit der Experten (Mainstream) – im Vergleich zu den Gruppen der Ausreißer nach oben und unten – in der Mitte des simulierten Verlaufs liegt. Dennoch stimmt keiner der Werte mit der simulierten Verteilung überein: Minimalwert und wahrscheinlichster Wert wurden zu hoch geschätzt, während der Maximalwert viel zu niedrig angesetzt ist. Die Verteilung der unteren Ausreißer spiegelt eine zu positive und Risiko-unterschätzende Ansicht wider. Der Verlauf der oberen Ausreißer weist eine Überdramatisierung möglicher Verluste auf – sowohl beim Maximalwert als auch beim wahrscheinlichsten Wert.

Abbildung 4: Vergleich von Experteneinschätzungen mittels Extremwerten mit Verteilungsabweichungen von bis zu 500 %.

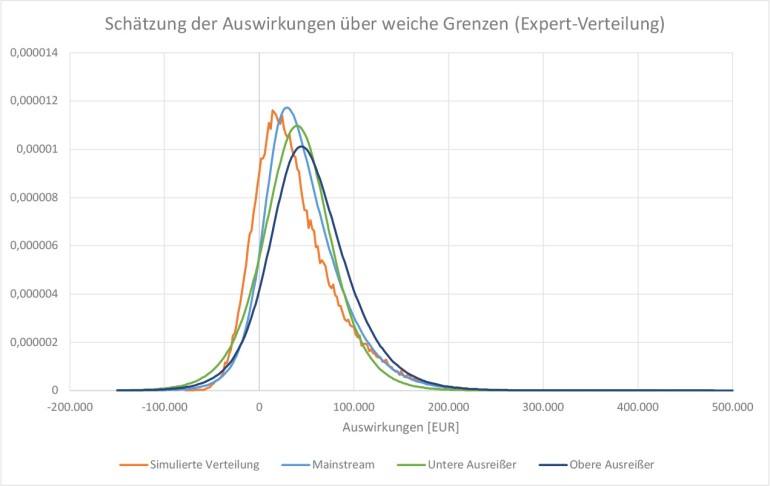

Eine so große Streuung zeigt, dass Extremfälle offenbar zu abstrakt und schwer vorstellbar sind. Demzufolge fallen die Werte ungenau und zu subjektiv aus. Jeder Fehler oder jede Ungenauigkeit in einer Risikoeinschätzung verfälscht hierbei das Endergebnis, wodurch dieses unzuverlässig wird. Bei der Einschätzung von Quantilen wurden die Experten hingegen nach Werten gefragt, die „ziemlich sicher“ nicht überschritten würden (mit einer Wahrscheinlichkeit von 90 %). Diese Schätzungsergebnisse lagen deutlich dichter beieinander und an der simulierten Verteilung – die Abweichungen betrugen weniger als 10 %.

Auffällig war dabei, dass die Teilnehmer länger und gründlicher über die einzelnen Werte nachdachten und diese auch diskutierten. Die Disaggregation in einzelne Faktoren erhöhte maßgeblich den Zugang zum Risiko. Als besonders schwierig wurde die Beurteilung des Realistic Best Case empfunden.

In Abbildung 5 ist erkennbar, dass alle Verteilungen die gleichen weichen Grenzen aufweisen und sich nur in ihrer Form leicht unterscheiden: Die simulierte Verteilung ist linksseitig steiler und hat rechtsseitig einen flacheren Abfall als die Verläufe der Expertenschätzungen – auch die wahrscheinlichsten Werte der Verteilungen sind leicht versetzt. Die hohe Übereinstimmung und geringe Streuung der verschiedenen Experteneinschätzungen lassen auf höhere Transparenz schließen. Dadurch, dass die einzelnen Parameter diskutiert und begründet werden konnten, sind die Werte objektiver, genauer und verlässlicher. Der methodische Ansatz mit Parametern in flexibleren Dimensionen scheint die Risikoeinschätzung in dem Experiment eindeutig anschaulicher und präziser durchführbar zu gestalten sowie für sicherere Ergebnisse zu sorgen.

Abbildung 5: Vergleich der Experteneinschätzungen von Quantilen und weichen Grenzen mit Abweichungen von unter 10 %.

Das OMNITRACKER Risk Management unterstützt Sie bei allen wichtigen Risikomanagement-Aufgaben wie Risiken erfassen und priorisieren, automatische Erinnerungen und Eskalationen sowie die Erstellung von Reports und Nachweisen. Den Demoraum können Sie 30 Tage kostenlos und ohne lokale Installation testen.

Einfach ist oft schlecht

Bei einer anstehenden Risikoquantifizierung stellt sich stets die Frage, ob eine Vorkalkulation gemacht werden muss, ob Experten zurate gezogen werden sollen oder eine Monte-Carlo-Simulation den Aufwand der Modellprogrammierung und Ergebnisauswertung rechtfertigt. Die Nutzung von Experteneinschätzungen – also Risikoexperten, die mögliche Risiken identifizieren und beurteilen – bedeutet den geringsten Aufwand.

Wie das beschriebene Experiment zeigt, können Ergebnisse von Experteneinschätzungen jedoch sehr unterschiedlich ausfallen: je nach genutzten Daten, verlangten Werten und Komplexität des betrachteten Risikos. Auch die Motivation spielt eine große Rolle bei der Qualität der Risikoquantifizierung: Liegt der Fokus auf einer schnellen Bearbeitung oder dem Ziel, Sicherheit zu vermitteln, kann das Ergebnis ungenau und beschönigt ausfallen. Ungenaue Werte kommen gleichermaßen zustande, wenn eine Überforderung vorliegt: Komplexe Risiken und deren schlimmstmögliche Auswirkungen einzuschätzen, kann trotz langjähriger Berufserfahrung schwer greifbar und vorstellbar sein. Daher sind eine Disaggregation komplexer Risiken und die Beurteilung der einzelnen Unsicherheiten sowie die anschließende Aggregation unerlässlich für realistische Einschätzungen. Wird der Prozess zu stark vereinfacht und standardisiert, führt jedoch auch dies zu einer Verfälschung der Ergebnisse. Während Experten ansonsten vielleicht nicht fähig sind, das gesamte Ausmaß zu erfassen, kann eine Standardisierung doch einen ähnlichen Effekt erzeugen wie die Nutzung von Extremwerten: eine zu geringe Differenzierbarkeit und zu unspezifische Aussagen.

Damit Experteneinschätzungen fundiert und verlässlich werden, benötigt es also das richtige Maß an Vereinfachung – unterstützt von hilfreichen Tools wie einer Monte-Carlo-Simulation – und einen Fokus auf eine qualitativ hochwertige Risikoquantifizierung.

Darüber hinaus kann es von großem Vorteil sein, Risikoexperten mit Risikomanagern zusammenarbeiten zu lassen: So kann der Experte den Sachverhalt dank seiner Berufserfahrung präzise darlegen und der Risikomanager diesen beurteilen. Damit wird statt des „reinen“ Risikos der Sachverhalt bewertet, was zu einer fundierteren und validierbareren Risikoquantifizierung führt. Empfehlenswert ist zudem eine regelmäßige Rückmeldung zu den einzelnen Risikoeinschätzungen, sodass sich Fehleinschätzungen und Ungenauigkeiten im Nachhinein erkennen und künftig besser vermeiden lassen.

Gute Risikoquantifizierung unterstützt Governance, Compliance und IKS

Sei es durch den IDW-Prüfungsstandard 340 (n. F.), aufgrund einer Zertifizierung oder für eine Ausschreibung: Risikoeinschätzungen erfolgen häufig dann, wenn bürokratische Anforderungen eingehalten werden müssen oder sollen. Der Fokus liegt dabei leider oft auf Zeit- und Kostenersparnis: Die Risikoeinschätzung soll schnellstmöglich vorweisbar sein und spielt darüber hinaus keine größere Rolle mehr – Ziel ist es, den Anforderungen möglichst preiswert formell gerecht zu werden und dadurch Strafen zu vermeiden. Das Potenzial, das eine in die Unternehmenssteuerung integrierte Risikoquantifizierung birgt, bleibt so allerdings ungenutzt. Dabei können auch die Bereiche Governance und Compliance sowie das interne Kontrollsystem (IKS) von einer fundierten Risikoeinschätzung deutlich profitieren.

Governance

- Bessere Entscheidungsfindung: Die präzisere Beurteilung und Priorisierung von Risiken sowie leichtere Erkennung von Chancen bilden eine verlässlichere Datengrundlage für ausstehende Entscheidungen (PDCA-Zyklus) und ermöglichen eine effizientere Unternehmenssteuerung sowie Entwicklung von Strategien.

- Bessere Kommunikation: Eine höhere Transparenz im Bereich Risikotragfähigkeit ermöglicht der Unternehmensführung eine offenere und vertrauensvollere Kommunikation mit Kunden, Geschäftspartnern, Investoren, Aktionären et cetera.

- Leichtere Identifizierung und Steuerung von Top-Risiken: Durch eine sorgfältige Risikoeinschätzung lassen sich die Risiken mit der größten Auswirkung einfacher beleuchten und gezieltere Gegenmaßnahmen finden.

Compliance

- Leichtere Einhaltung von Anforderungen und Gesetzen: Mithilfe einer Risikoquantifizierung lassen sich Risiken in Bezug auf Compliance-Vorschriften bewerten, wodurch deren Einhaltung einfach(er) gewährleistet und dokumentiert werden kann.

- Bessere Prüfbarkeit: Eine fundierte Risikoquantifizierung liefert validierbare, verlässliche Werte, die fälschungssicher dokumentiert sind – ideal für Reports und Nachweise. Außerdem lassen sich so klare Verantwortlichkeiten festlegen und nachvollziehen.

- Vorausschauende Maßnahmenplanung: Die Früherkennung von Risiken und gefährlichen Entwicklungen ermöglicht auch das frühzeitige Ergreifen von Gegenmaßnahmen, wodurch Risiken schneller minimiert werden können.

Internes Kontrollsystem (IKS)

- Effizienteres Ressourcenmanagement: Mit einer strategischen Priorisierung von Risiken und Maßnahmen lässt sich das IKS gezielt unterstützen, indem Ressourcen zur Verbesserung des IKS zugewiesen werden.

- Lückenlose Überwachung: Mit den Ergebnissen einer Risikoeinschätzung kann man eine umfassende Überwachung des IKS sicherstellen.

Fazit

Eine Risikoquantifizierung mag häufig aufgrund einer konkreten Anforderung angestoßen und durchgeführt werden – allerdings sollte das darüber hinausgehende Potenzial, das eine solche Einschätzung birgt, nicht ungenutzt bleiben. Werden realistische und verlässliche Parameter (Quantile) als weiche Grenzen in Kombination mit einer Monte-Carlo-Simulation und einer kalibrierbaren Verteilung (Poly- oder Expert-Verteilung) verwendet, gibt eine Risikoeinschätzung nicht nur einen verlässlichen Überblick über die Risikotragfähigkeit eines Unternehmens, sondern bietet weitere signifikante Vorteile:

- Früherkennung bestandsbedrohender Entwicklungen und Risiken

- stärkere Resilienz durch bessere Compliance

- mehr Transparenz bezüglich der Risikolandschaft

- mehr Maßnahmeneffizienz durch gezielte Priorisierung und Dokumentation von Risiken

- bessere Ressourcenplanung dank fundierter und validierbarer Werte

- Kostenreduzierung durch zeitnahes Vermeiden von Risiken und Erkennen von Chancen

Zu den Autoren

Dipl. Ing. Andreas Chlebnicek war lange Zeit im Automotive- sowie PKI-Umfeld als Software-Entwickler tätig, bevor er in die Beratung wechselte – seit 2021 ist er Head of Governance, Risk and Compliance (GRC) Management bei OMNINET.

Dipl. Ing. Andreas Chlebnicek war lange Zeit im Automotive- sowie PKI-Umfeld als Software-Entwickler tätig, bevor er in die Beratung wechselte – seit 2021 ist er Head of Governance, Risk and Compliance (GRC) Management bei OMNINET.

Dr. Uwe Wehrspohn berät Unternehmen in der Anwendung moderner Methoden zur Messung und Steuerung von Risiken und Erträgen – er ist Geschäftsführer der Wehrspohn GmbH & Co. KG und Research Fellow am Forschungszentrum Risikomanagement der Universität Würzburg.

Dr. Uwe Wehrspohn berät Unternehmen in der Anwendung moderner Methoden zur Messung und Steuerung von Risiken und Erträgen – er ist Geschäftsführer der Wehrspohn GmbH & Co. KG und Research Fellow am Forschungszentrum Risikomanagement der Universität Würzburg.

Dieser Artikel erschien bereits im Fachmagazin <kes> – die Zeitschrift für Informations-Sicherheit, Ausgabe 2023 #6, S. 60ff.